En nuestro empeño por comprobar si una Inteligencia Artificial (IA) es capaz de superar las capacidades mentales humanas, de reinventarse y mejorarse a sí misma, de alcanzar en definitiva el nivel de la singularidad, hemos establecido ya las dimensiones y los requisitos físicos (el hardware) que debería tener un ordenador de capacidad equivalente a la del cerebro humano.

Además de pensar como un humano, este cerebro sintético debería estar diseñado para aprender por sí solo, para adquirir consciencia de sus actos y para sentirse responsable de sus decisiones.

El aprendizaje

Si pretendiera competir con un ordenador jugando al ajedrez, seguramente tendría todas las de perder. La máquina es más rápida y segura que mi mente, pero, aun reconociendo esta inferioridad, yo tengo una ventaja sobre ella: puedo mejorar mediante el aprendizaje y el entrenamiento.

Para equiparar al ordenador con la mente humana tenemos que ser capaces de enseñarle a aprender.

Cuando en su momento hablábamos de los sistemas expertos, hicimos un pequeño ejercicio en el que dotábamos de conocimientos a un ordenador mediante la codificación de reglas. Este procedimiento suponía la implicación de expertos en la disciplina que se quería transferir y requería además de una supervisión humana durante el proceso de aprendizaje.

Para que el lector se haga una idea de lo complicado que puede resultar esta empresa, pensemos en qué necesitaríamos para enseñar a un ordenador a interpretar el lenguaje natural utilizando el sistema de reglas. Un experto lingüista debería asesorar al programador para que codificase las normas ortográficas y gramaticales, integrándolas dentro del programa en forma de reglas. Lógicamente deberían explicitarse asimismo todas las excepciones que existen en esas normas (por ejemplo, los verbos irregulares) y, por desgracia, el lenguaje suele tener tantas excepciones como reglas.

Pero ahí no acabaría el problema. El lenguaje es ambiguo y consecuentemente también habría que aleccionar a nuestro ordenador para que fuera capaz de resolver las ambigüedades. Por ejemplo: “Juan no quiere a Pedro porque es envidioso”. No sabemos quién es envidioso, Juan o Pedro.

En definitiva, enseñar a un ordenador no es tarea fácil y requiere por lo general un gran esfuerzo humano. En la corta historia de la IA, han ido sucediéndose mecanismos de aprendizaje basados en algoritmos diversos y ninguno de ellos ha sido capaz de resolver este problema.

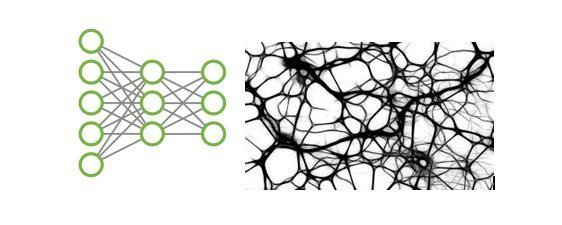

Esta es la razón por la que el desarrollo de las técnicas Deep Learning sobre redes neuronales ha supuesto una verdadera revolución en el campo del aprendizaje maquinal. Estas técnicas permiten al ordenador aprender por sí mismo y mejorar sus conocimientos autónomamente mediante el entrenamiento.

Las redes neuronales quieren imitar el funcionamiento del cerebro humano o, al menos, replicar su arquitectura física. Se basan en núcleos de procesamiento interconectados entre sí análogamente a como se enlazan las neuronas en el cerebro (conexiones sinápticas). Estos núcleos o neuronas artificiales se conocen con el nombre de perceptrones.

Los perceptrones actúan en diferentes niveles y cada uno de ellos está conectado solo a otros del nivel inmediatamente superior o inferior. El primer nivel recibe estímulos del exterior, los procesa y genera entradas para el segundo nivel y así sucesivamente hasta el más alto en la jerarquía, que es el que integra y procesa la información completa.

Imaginemos, por ejemplo, que una red neuronal artificial tratara de reconocer la cara de un león.

Una cámara de televisión captaría su imagen completa, descomponiéndola en múltiples puntos cromáticos (píxeles). Cada píxel es tratado por un perceptrón de primer nivel, que analiza una serie de atributos ligados a esa imagen minúscula (color, brillo, longitud, grosor, ángulos, distancias entre puntos, posiciones relativas, etc.). El perceptrón tiene en cuenta todos esos atributos, asignando a cada uno de ellos un nivel de importancia dentro del proceso de reconocimiento, es decir un peso. Este conjunto de atributos y sus pesos asociados constituyen lo que se llama patrón de reconocimiento.

Aplicando un algoritmo sobre ese patrón, el perceptrón decide si lo que ve es o no un fragmento de la cara de un león. Esta información, junto con la suministrada por el resto de perceptrones del mismo nivel se combina sucesivamente con las de los siguientes niveles neuronales hasta completar el reconocimiento en el nivel superior.

El secreto del éxito está en que cada una de estas neuronas artificiales elija de forma adecuada los atributos y los pesos, es decir, el patrón de reconocimiento.

Afortunadamente y gracias a Internet, la máquina tiene a su alcance millones de imágenes de leones para poner delante de su red neuronal. Mediante entrenamiento, analizando esos millones de imágenes, cada perceptrón ajusta por sí mismo su patrón de reconocimiento y, una vez conseguido, la máquina es capaz de identificar la imagen del león en cualquier escenario.

En realidad, lo que llegaría a reconocer la red neuronal es el patrón global de la cara del león, es decir las relaciones (posiciones relativas, ángulos, etc.) entre las diferentes partes que la componen, relaciones que se mantienen siempre, independientemente de que la imagen que se muestre esté oscura, girada o invertida.

Si habláramos de procesamiento del lenguaje natural, nos olvidaríamos ya de codificar reglas ortográficas y gramaticales. Sería suficiente con someter a la red neuronal a un entrenamiento basado en el procesamiento de millones de textos escritos.

En algún momento y en entregas anteriores de esta serie, mencionábamos a AlphaGo, la máquina desarrollada por la división de IA de Google (Google DeepMind) que fue capaz de derrotar en 2015 al campeón europeo de Go (una especie de juego de damas o ajedrez chino).

La nueva versión de esta máquina (AlphaGo Zero), desarrollada recientemente, cuenta con un algoritmo de aprendizaje basado en redes neuronales.

Sin entrenamiento previo, partiendo de cero, en poco más de dos días y tras jugar contra sí misma más de cuatro millones de veces, AlphaGo Zero fue capaz de derrotar a su versión precedente.

Todo parece indicar que el Deep learning y las redes neuronales muestran el camino a seguir en lo que al aprendizaje maquinal se refiere, aunque apenas estemos aun dando los primeros pasos. Su complejidad las relega de momento a escenarios de aplicación bastante restringidos, pero no es difícil imaginar a corto plazo su uso generalizado en muchos campos relacionados con la IA.

La consciencia, el libre albedrío y los sentimientos

El procesamiento de la información a partir del aprendizaje (lo que llamamos razonamiento) es una capacidad básica de la mente humana, pero no es la que más intrínsecamente está ligada a su esencia.

En alguna de las entregas anteriores de esta serie utilizábamos el traductor de Google para traducir al inglés la siguiente frase: “Hoy en día las aplicaciones de traducción han mejorado y se han convertido en herramientas de uso común en la actualidad”.

La traducción que hacía el programa de Google era esta: “Nowadays the applications of translation have improved and they have become tools of common use at present”.

En paralelo, un británico nativo lo ha traducido así: “Over time the translation tools have improved and are now commonly used”.

La interpretación de un segundo nativo ha sido esta: “Nowadays translation apps have improved and are widely used”.

No hay coincidencia en ninguno de los casos porque en las versiones del ser humano existe una importante componente de subjetividad.

Esta percepción subjetiva de la realidad es la base de lo que conocemos como consciencia.

El libre albedrío, el sentido común, el ingenio, la creatividad y los sentimientos son los atributos que en realidad definen al ser humano. Todos ellos se derivan de esta particular capacidad cerebral que llamamos consciencia.

Los ordenadores se construyen bajo principios de ingeniería y consecuentemente sus actuaciones son siempre predecibles. Si pedimos a uno de ellos que pinte un cuadro, lo hará siempre siguiendo las directrices que su programador le haya inculcado y se mostrará incapaz de crear algo personal o genial, como podrían hacerlo Velázquez o Picasso.

Es esta visión subjetiva de las cosas lo que al día de hoy distingue por encima de todo al ser humano de las máquinas y es el gran reto al que se enfrenta la singularidad.

Uno de los padres del pensamiento científico y filosófico del siglo XX, Kurt Gödel, estableció en sus “Teoremas de la incompletud” (1931) que existen verdades que no son demostrables ni reconocibles como tales utilizando estrictamente razonamientos lógicos o postulados matemáticos y solo resultan serlo cuando se aplica el sentido común. Sobre la base de este principio, una máquina nunca podrá percibir la realidad tal cual es en tanto sea incapaz de analizarla de forma subjetiva.

¿Será posible algún día crear máquinas conscientes, capaces de interpretar a su modo la realidad?

Como siempre, existen distintos puntos de vista sobre el problema y también distintas respuestas a esa pregunta.

Muchos de los que investigan en el campo de la IA nos recuerdan que todo lo que somos y hacemos surge de unos cuantos millones de partículas subatómicas. El cerebro humano no es en realidad más que un conjunto de electrones, protones y neutrones, ligados unos a otros de acuerdo con una determinada configuración.

Según ellos, la consciencia aparece en nuestro cerebro exclusivamente como consecuencia de alguna ley de la naturaleza. Si alguien fuera capaz de descifrar esa ley o de reproducir esa específica configuración de partículas subatómicas que da forma al cerebro, replicaría también todas sus funciones.

Alcanzar temperaturas por debajo del cero absoluto o desplazarnos más rápidos que la luz son empresas utópicas. Hay leyes de nuestro universo que nos dicen que esto es imposible. Sin embargo, no existe ninguna ley física conocida que impida replicar exactamente la configuración de partículas que componen nuestro cerebro. Todo se reduce a contar con la tecnología adecuada.

Pensemos en lo que esto significa. Si fuéramos capaces de copiar exactamente el cerebro humano, podríamos construir seres artificiales dotados de consciencia, de libre albedrío, de genio y de sentimientos. Pero también podríamos “descargar” nuestra mente en un cerebro artificial y vivir dentro de un cuerpo enteramente sintético. No habría ya más enfermedades ni razón alguna para morir.

Si realmente la consciencia es tan solo una función ejecutada por un conjunto de partículas replicable, es difícil responder a muchas preguntas que enseguida nos asaltan: ¿por qué, en una misma configuración de partículas, pueden albergarse unos pensamientos y momentos después los contrarios?, ¿por qué durante la noche, mientras dormimos, perdemos la consciencia si la configuración del cerebro es la misma?, ¿por qué algunas habilidades que son conscientes se convierten en inconscientes (por ejemplo, montar en bicicleta) si las partículas del cerebro no han cambiado?, ¿por qué muchas veces el cerebro responde a estímulos antes de percibirlos conscientemente (reflejos) ? ¿Qué configuraciones de partículas son capaces de albergar consciencia y cuáles no? ¿Por qué unas sí y otras no? ¿Qué específicas propiedades de las partículas marcan la diferencia?

Los más espiritualistas opinan que la respuesta está en las palabras del poeta: “¡cuántas veces el genio así duerme en el fondo del alma…!”. La inteligencia humana, la consciencia, el libre albedrío y los sentimientos son más que unos cuantos átomos de carbono y emanan de algo no sometido a leyes físicas que se llama alma.

Desde un punto de vista estrictamente científico, tanto la visión “materialista” como la “espiritualista” son en la misma medida creíbles o increíbles.

El filósofo Karl Popper, en su obra La lógica de la investigación científica, estableció un criterio de demarcación que distinguía entre lo que son planteamientos científicos de lo que son metafísicos. Según este criterio, generalizado y aceptado por la comunidad científica, cualquier planteamiento para el que no exista procedimiento ni medios de demostrar que es falso, no es científico.

No existe forma de demostrar que la consciencia reside en el alma o que por el contrario se soporta en una base de partículas elementales. Tampoco puede demostrarse lo contrario. En consecuencia, ambos postulados escapan al planteamiento científico.

Llegando a este punto, sabemos ya que la tecnología permite o va a permitir en los próximos años construir físicamente réplicas de la mente humana en ordenadores, que se podrá emular sin dificultades la forma en que el cerebro procesa la información y que será posible además crear máquinas capaces de aprender por sí solas. Tenemos, sin embargo, muchas dudas cuando nos preguntamos si esas máquinas llegarán alguna vez a ser conscientes y si podrán albergar sentimientos humanos, aunque no conocemos principios ni leyes físicas que a priori lo impidan.

Asumiendo la visión más ambiciosa, queremos preguntarnos cómo sería el mundo si tuviéramos que convivir con máquinas conscientes y más inteligentes que nosotros, indagar en los riesgos a los que estaríamos sometidos y en la forma de sociedad que debería acoger a esta convivencia.

Cerraremos la serie sobre inteligencia artificial con una última entrega en la que abordaremos todas estas cuestiones.

Zenda es un territorio de libros y amigos, al que te puedes sumar transitando por la web y con tus comentarios aquí o en el foro. Para participar en esta sección de comentarios es preciso estar registrado. Normas: