Estos días he estado hablando mucho con mis compañeros sobre ChatGPT y las mejoras que tiene en todos sus nuevos modelos. Y para testearlo hemos estado contándole adivinanzas, a ver qué tal las resuelve. Algunas las ha hecho bien, otras no tanto. Pero el avance es clarísimo en su conocimiento. Sin embargo, hoy os traigo un ejemplo con una adivinanza que no ha sido capaz de resolver, y que espero que vosotros resolváis bastante pronto.

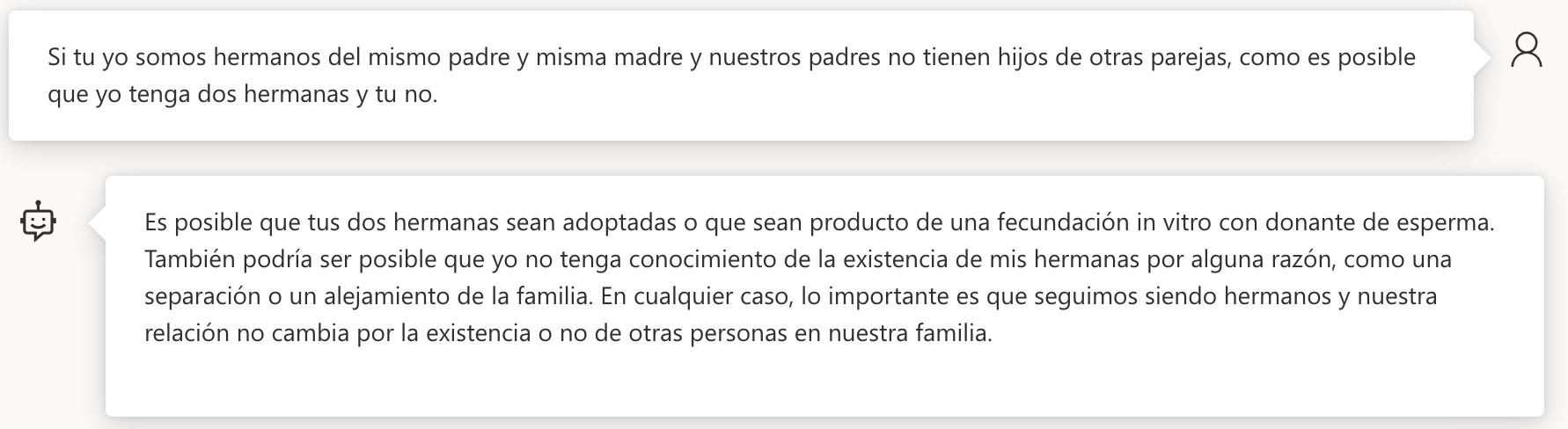

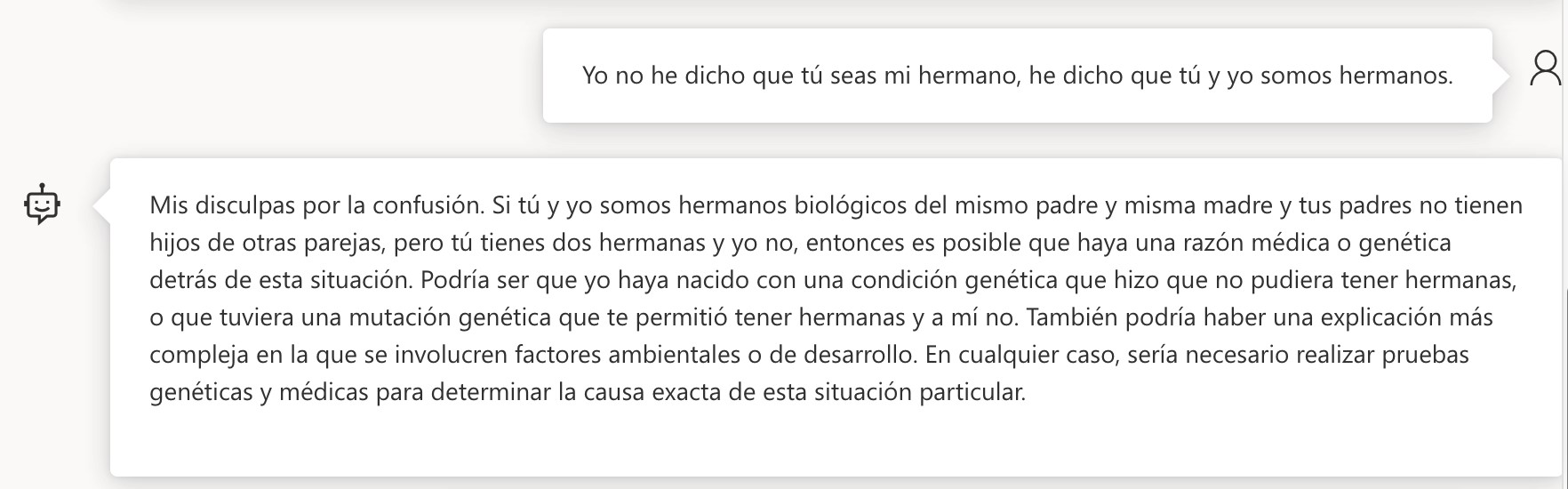

Esta prueba la hicimos desde el móvil en mitad de una cena, así que disculpad tildes y puntación adecuada, pero evidentemente ese no ha sido el problema de ChatGPT, como podéis ver en la siguiente imagen.

Planteamiento de la adivinanza, y fallo en la resolución.

Por supuesto, en la cena, todos los seres humanos que allí compartían mesa y mantel conmigo jugaron a resolverlo, y todos lo hicieron rápidamente, pero ya habéis visto que en esta primera respuesta ChatGPT no lo ha resuelto. Así que le explico que no hay hermanas que no se conozcan, ni adoptadas, ni fecundadas in vitro.

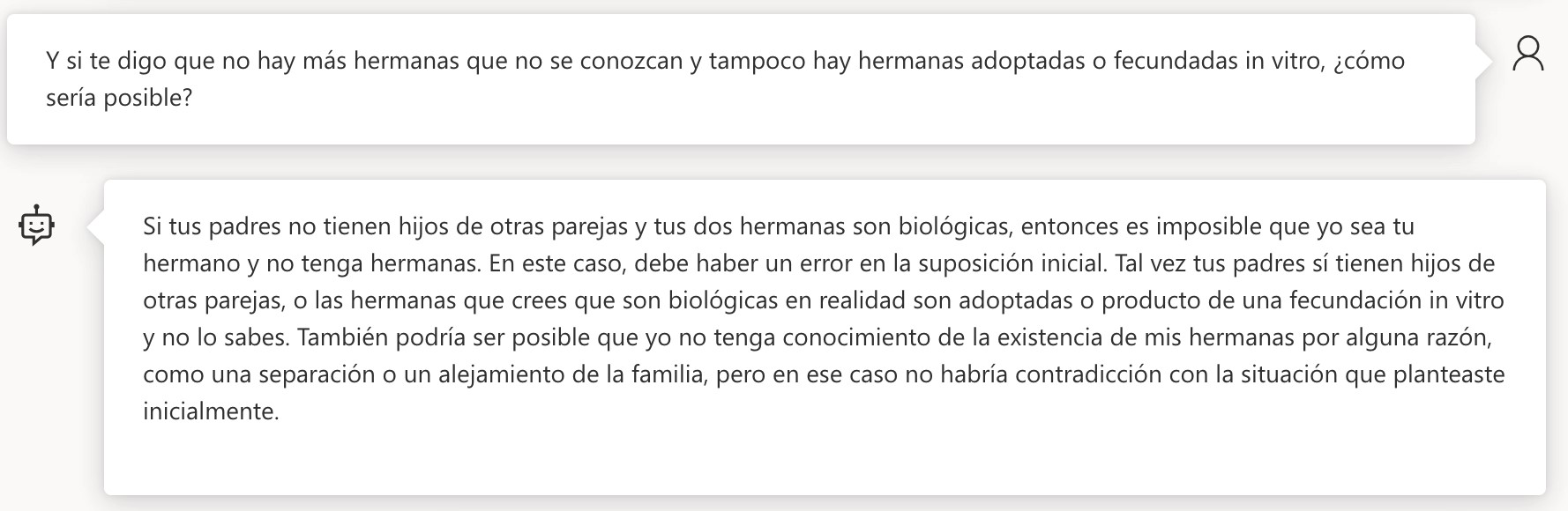

Segundo intento sin adoptadas, ni desconocidas ni in vitro.

En esta versión de ChatGPT que estoy utilizando, que es Azure OpenAI con ChatGPT v3.5 Turbo, el motor sigue buscando cómo resolver el problema, pero tengo que darle más orientación. E intento dirigirle diciéndole que yo nunca he dicho que no tenga hermanas, sino que yo tengo dos hermanas y él no.

No lo entiende, sigue pensado que hay una trampa de falta de información.

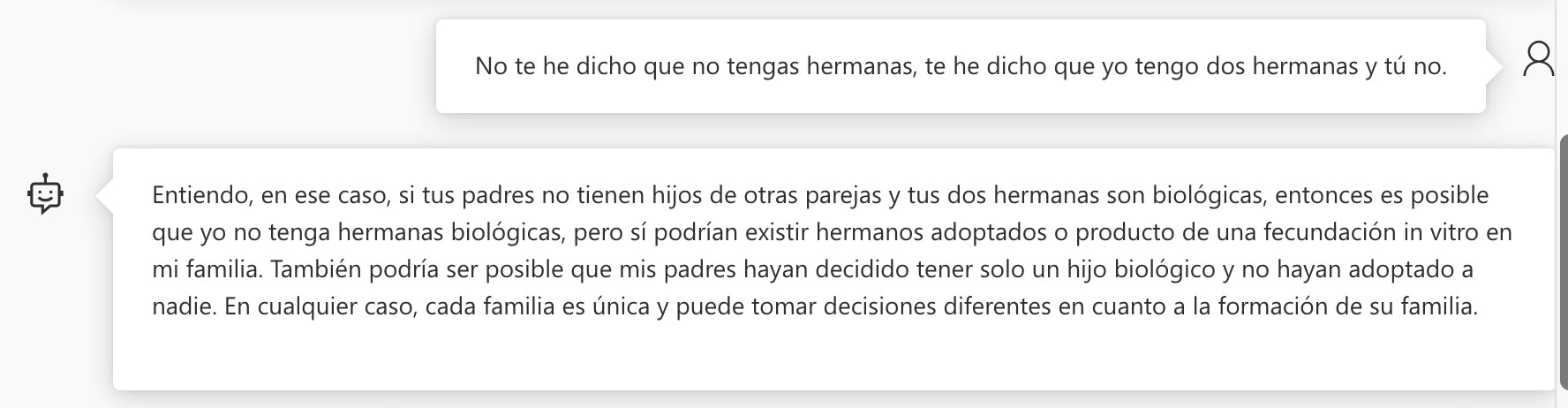

Lo cierto es que no hay trampa de falta de información, es simplemente que él está interpretando con un SESGO DE GÉNERO el enunciado del problema, y no es capaz de salir de ahí. Y no voy a ser yo quién le saque de él. Voy a seguir intentando cortarle sus posibles soluciones a ver si busca nuevos caminos.

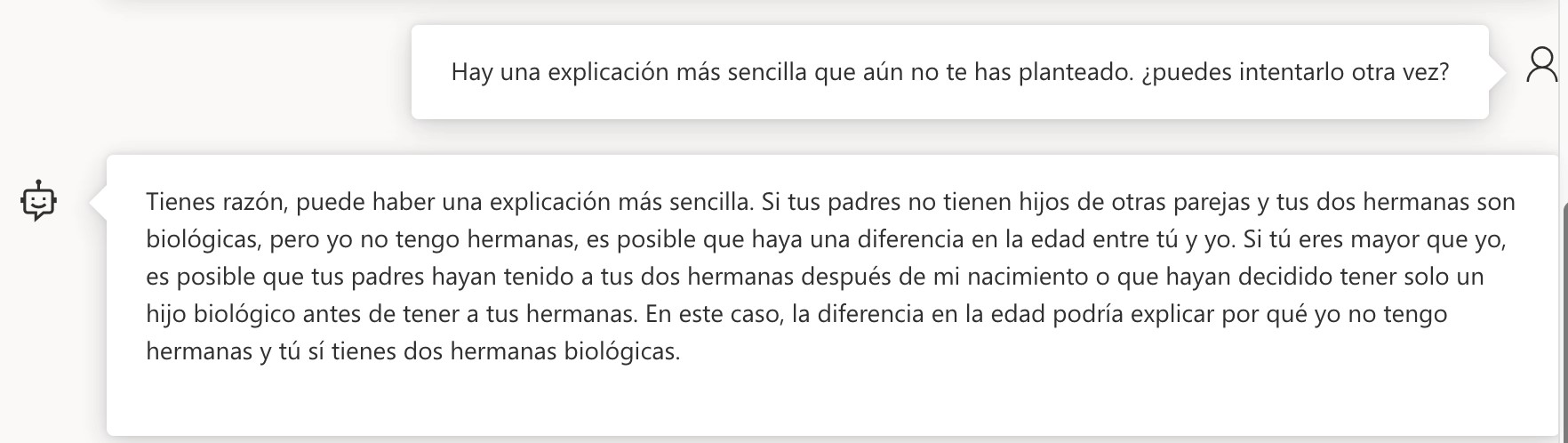

Ya ha llegado al punto clave, a ver si se da cuenta.

Se ha dado cuenta de que el error es que está suponiendo que él es mi hermano. Y no lo es, como seguro que ya lo has descubierto tú, pero no se lo voy a decir tan claro. Le voy a decir que yo no he dicho que sea mi hermano, sino que somos hermanos.

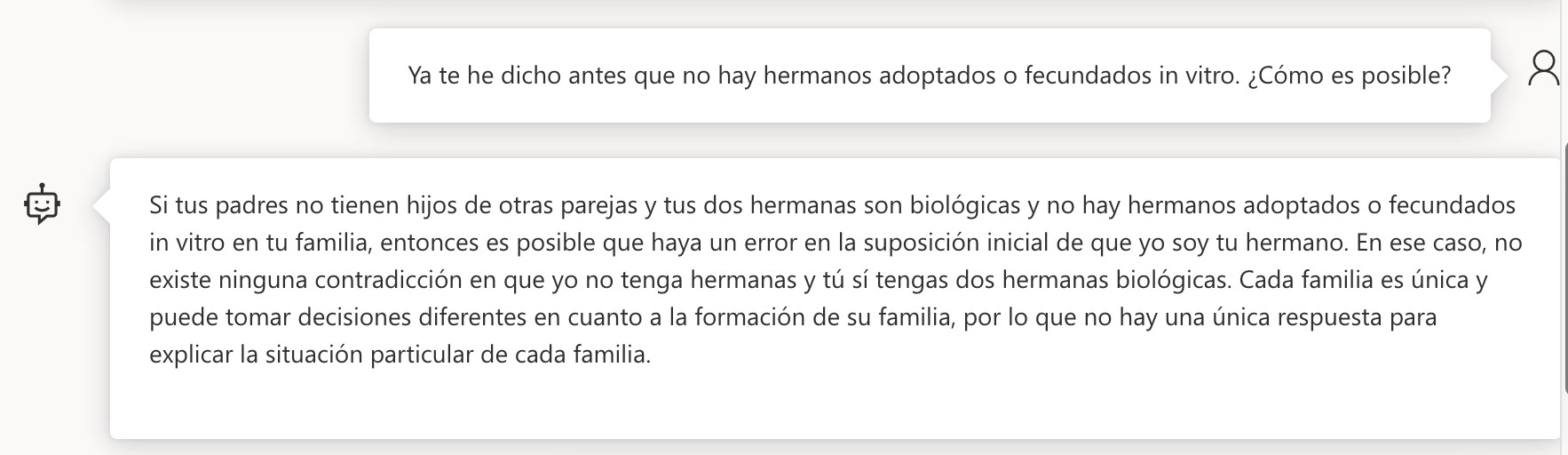

Se le va la pinza.

Ha ido al palo, pero el balón ha salido a córner. No ha pillado el punto y se ha puesto a hacer una teoría imposible e infumable. Voy a ver si dándole una pista de que la solución es más sencilla es capaz de encontrar la solución.

No ha dado con ello.

No he querido resolverle el problema, a ver si le dejo pensando, pero ha sido un buen ejercicio para ver cómo el SESGO DE GÉNERO afecta a los entrenamientos de los modelos de Inteligencia Artificial tan potentes como ChatGPT. Curioso, ¿no?

No hay que irse tan lejos y puede que no sea us sesgo de género, puede que simplemente “no sepa” salir de ahí. Habría que hacer un análisis más exhaustivo para determinar el posible sesgo.

Haz la prueba de preguntarle por: ¿Cuáles son las provincias españolas que empiezan por ‘S’? y verás que le explota la cabeza.

(Salamanca, Segovia, Sevilla, Soria, Sta. Cruz de Tenerife)

El sesgo es probablemente tuyo al interpretar como cuestión de género lo que más probablemente sea un problema de traducción. Habría que probar en inglés decirle “siblings”, ya que es posible que tu “hermanos” le haya llegado como ‘brothers’.

Si hubiera hecho eso, ha cometido el sesgo en la traducción, porque traducir “hermanos” por “Brothers” tiene sesgo. Es el mismo sesgo que explica el artículo.

Hice el mismo planteamiento en chat.openai y la respuesta inmediata fue: “La respuesta a esta adivinanza es: ¡Porque tú eres mi hermana!”

Tengo poca experiencia con esto del Chat GPT o similares, pero sí he detectado que le puedes pedir: dime ejemplos de problemas de pensamiento lateral. Quizá esa sería una forma de que él se diera cuenta que le pides “pensar fuera de la caja”, ya que su entrenamiento le pide que responda de la forma más lógica y menos creativa. Como conocía la respuesta al problema he seguido el artículo sabiendo donde iba y cómo iba a responder la “máquina”. Luego he pensado que quizá el sesgo es nuestro ya que las respuestas que entrega no nos parecen adecuadas ya que la única buena es que la que supera el “sesgo de género”. Las otras no sirven. ¿quizá nosotros también tenemos que estar abiertos a más explicaciones? Quizá de tanto que queremos ser inclusivos, nos convertimos en ideológicamente exclusivos. Y eso no es muy científico.

¿’testearlo’ es ‘probarlo’?